基本概念

什么是Ollama?

Ollama是一个专为在本地机器上便捷部署和运行大型语言模型(LLM)而设计的开源框架。旨在简化大型语言模型(LLM)的部署和管理过程。它允许用户在自己的设备上快速运行大模型,而无需依赖云端服务。

什么是 DeepSeek R1?

DeepSeek R1 是 DeepSeek AI 开发的第一代推理模型,擅长复杂的推理任务,官方对标OpenAI o1正式版,适用于多种复杂任务,如数学推理、代码生成和逻辑推理等。目前包括完整版(671B 参数)和蒸馏版(1.5B 到 70B 参数)。完整版性能强大,但需要极高的硬件配置;蒸馏版则更适合普通用户,硬件要求较低,本地部署的是蒸馏版。

本地部署

安装Ollama

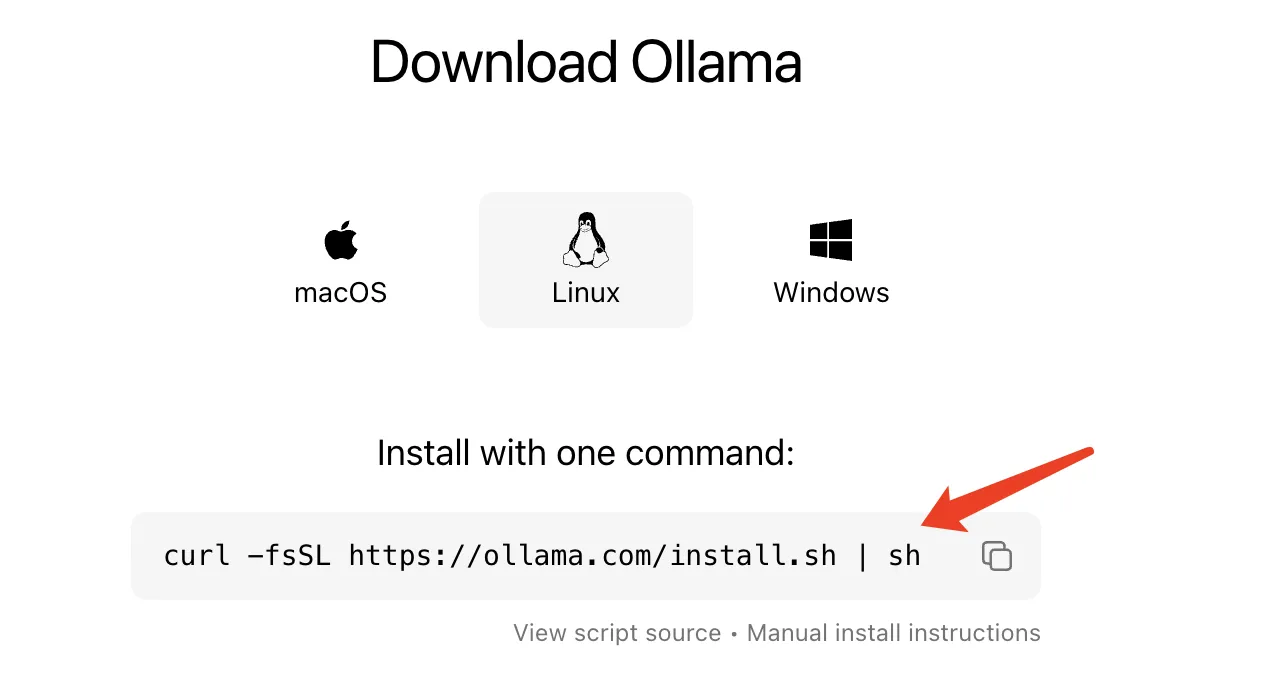

官方下载:https://ollama.com/download/linux

复制下面命令到服务器上执行(下面命令是一键下载安装包并解压和启动)

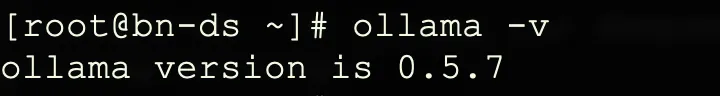

验证是否安装成功

# ollama -v

如上面安装包下载太慢,可以用电脑上已下载的安装包,然后手动解压和启动

# tar -C /usr -xzf ollama-linux-amd64.tgz

# ollama serve

# ollama -v

配置系统启动

# useradd -r -s /bin/false -U -m -d /usr/share/ollama ollama

# usermod -a -G ollama $(whoami)

# vi /etc/systemd/system/ollama.service

[Unit] Description=Ollama Service After=network-online.target [Service] ExecStart=/usr/bin/ollama serve User=ollama Group=ollama Restart=always RestartSec=3 Environment="PATH=$PATH" Environment="OLLAMA_HOST=0.0.0.0" [Install] WantedBy=default.target

# systemctl daemon-reload

# systemctl enable ollama

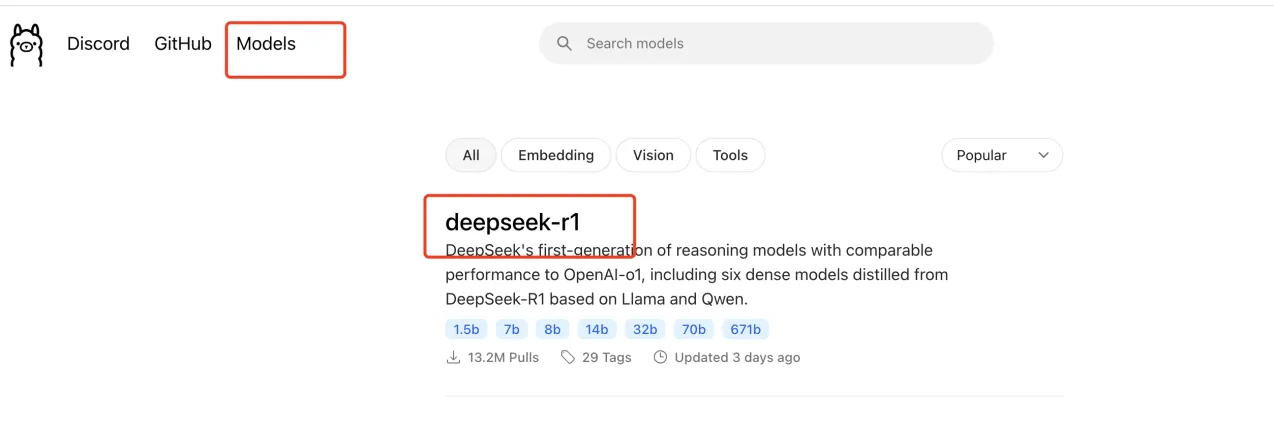

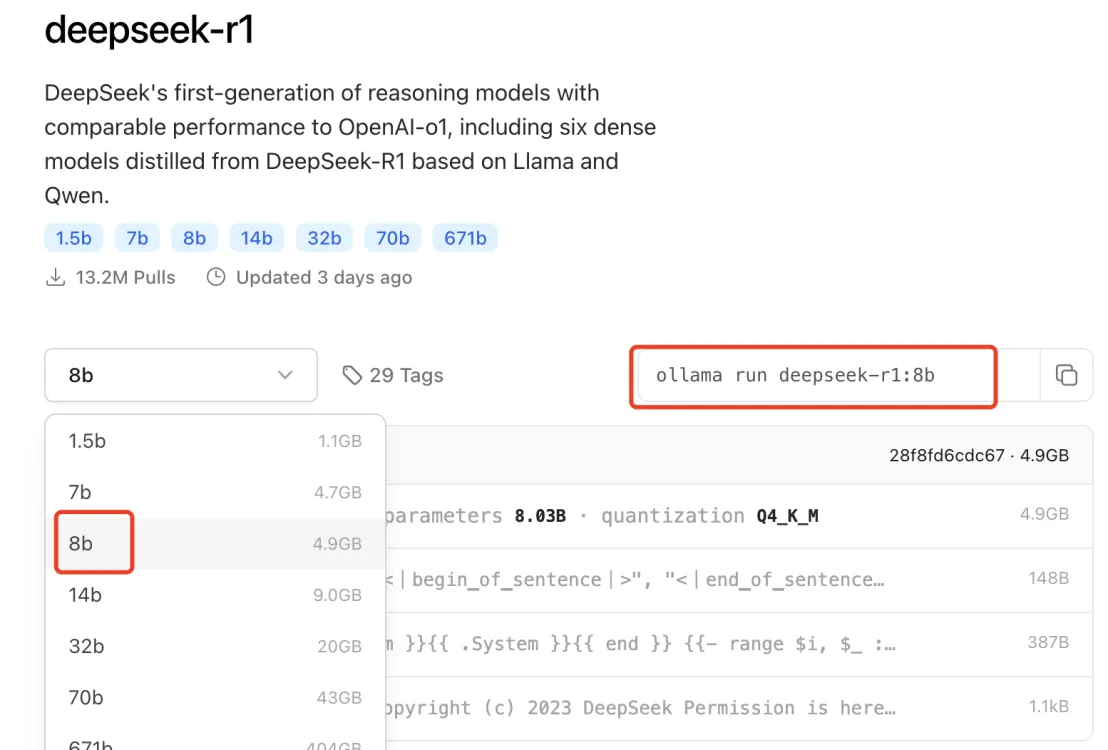

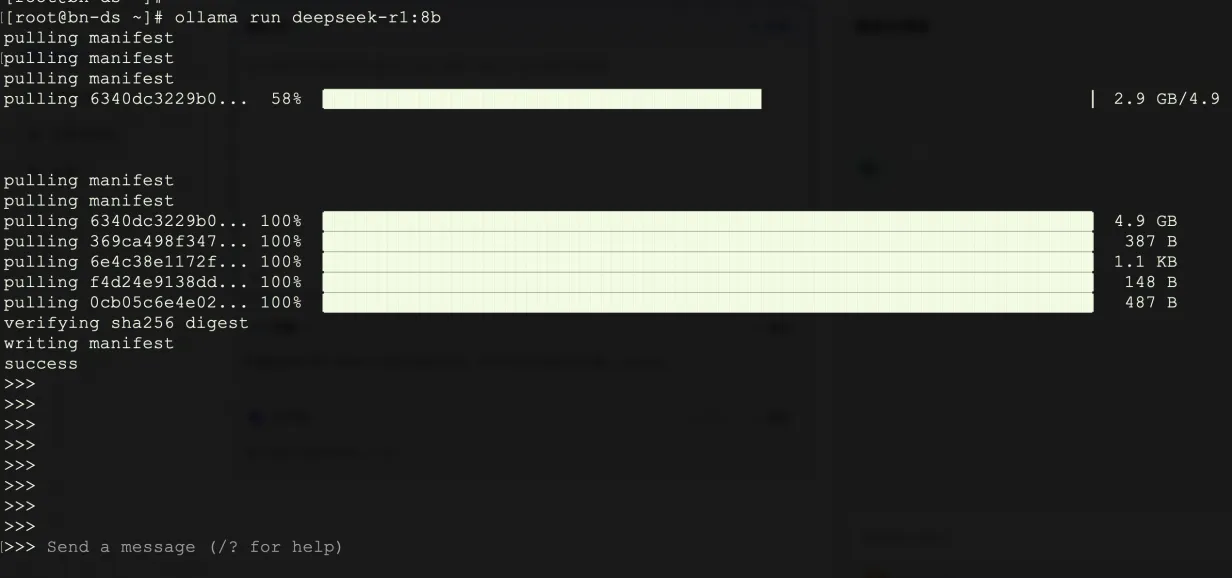

安装Deepseek

再回到ollama官网选择模型,选择需要的模型复制命令进行安装

安装可视化界面Dify

官方地址:https://github.com/langgenius/dify

Dify采用docker-compose部署,前提是有安装docker和docker-compose。

# git clone -b main https://github.com/langgenius/dify.git

# cd dify/docker

# cp .env.example .env

# docker-compose up -d

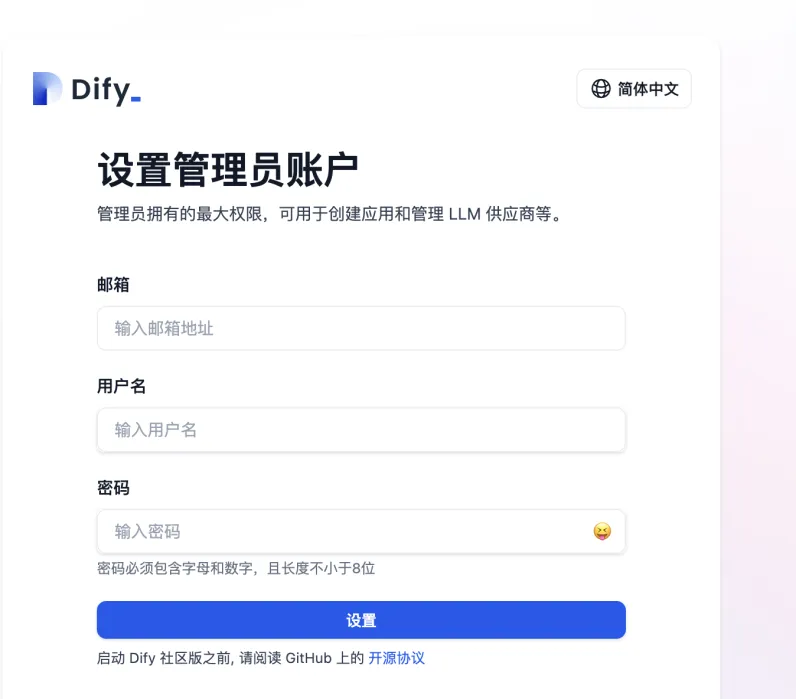

启动成功,浏览器输入http://xxx.xxx.xxx.xxx/install 即可进入初始化界面

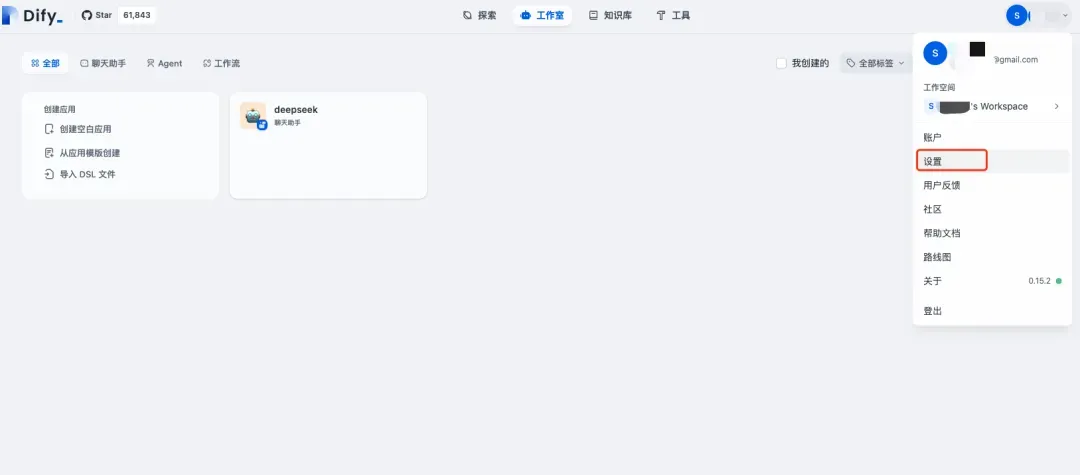

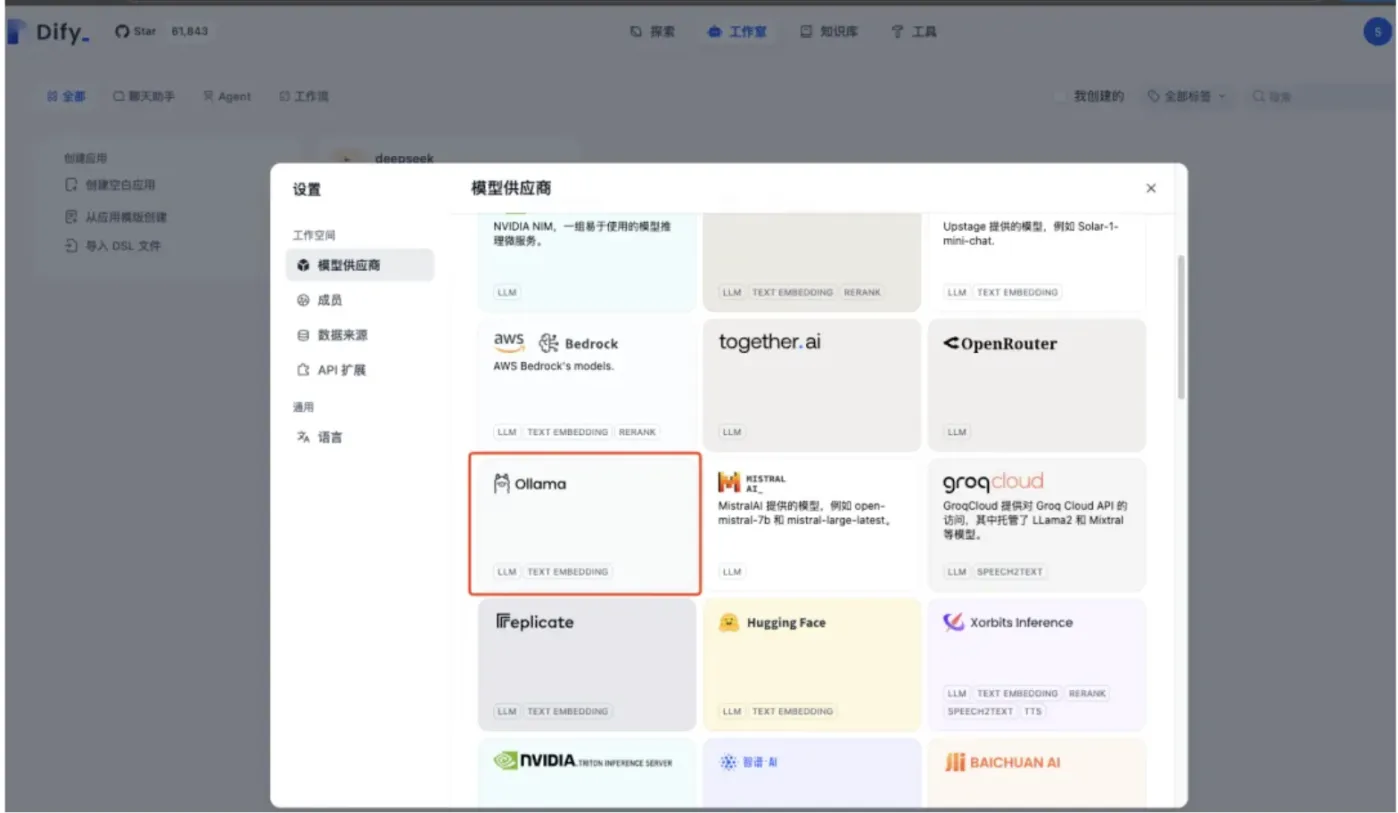

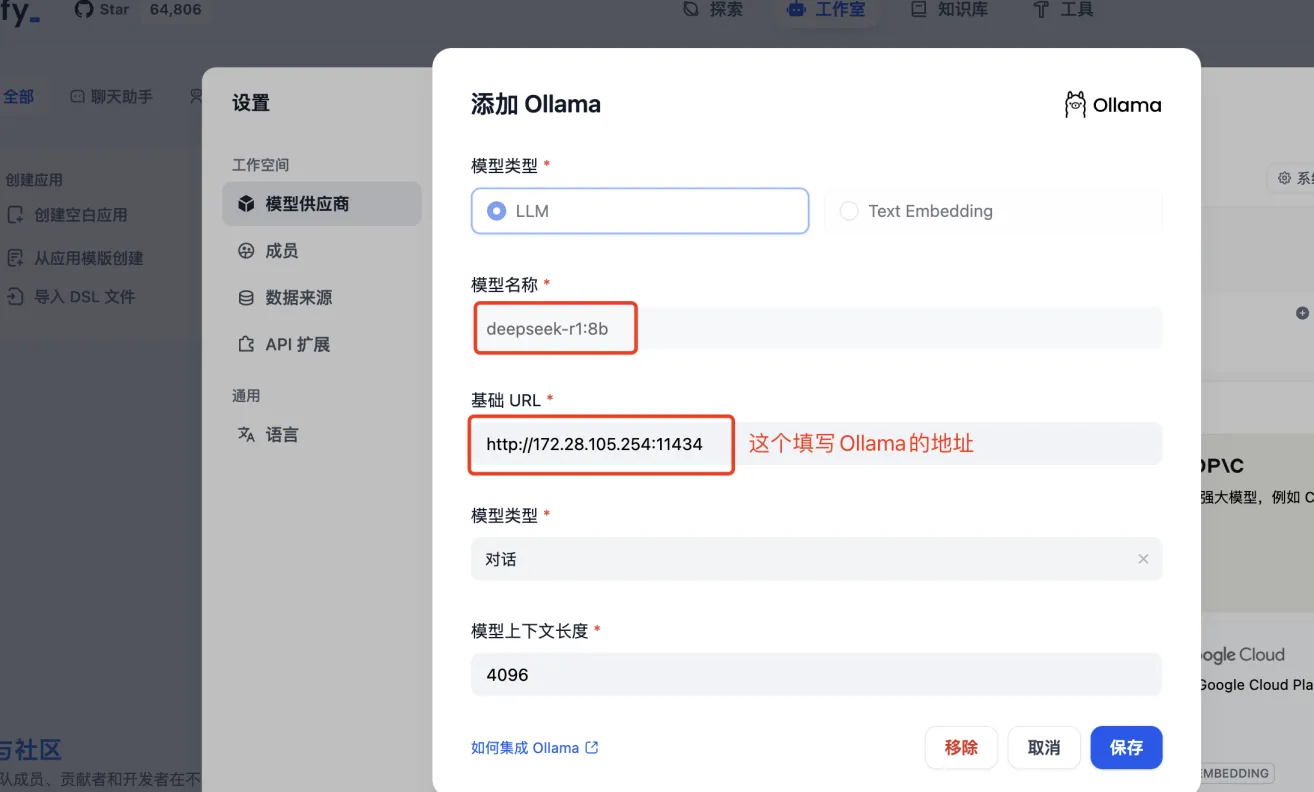

设置账密成功,登录之后添加Ollama模型

接下来创建应用使用之前安装好的DeepSeek R1模型